Hacernos mayores

Cuando era joven, elegí estudiar Ingeniería Aeronáutica, principalmente por dos motivos: porque tenía fama de ser muy difícil, y porque estaba obsesionado con un avión militar.

Descubrí el F-22 Raptor de Lockheed Martin/Boeing a raíz de un videojuego que vino con el periódico, y quedé enamorado. Esas formas angulosas, ese post-quemador que hacía muchísimo ruido y ponía el aparato a Mach 2, esa variedad infinita de misiles y bombas, esa superioridad abrumadora. ¿Cómo no admirarlo?

Años más tarde, aún durante la carrera, empecé a darme cuenta de que esas máquinas extraordinarias tenían un solo propósito: matar gente. Ya fueran de los malos o de los buenos. Sí, yo también fui joven.

Por culpa de esto, me fui alejando de los aviones militares y abracé mi siguiente pasión: el espacio.

¿Cómo no maravillarse escuchando a Carl Sagan? ¿Cómo no regocijarse leyendo el Tratado de la Luna de 1979, que llamaba a la exploración espacial pacífica y en beneficio de todos los países? ¿Cómo no pasar horas sin fin desarrollando las ecuaciones de la mecánica celeste, el problema matemático que más ha estimulado las mentes de los grandes genios de la historia?

Al terminar la carrera tuve el honor de trabajar en una empresa argentina que desarrollaba una constelación de satélites, y fue el trabajo de mis sueños. Jamás tuve compañeros tan inteligentes, bondadosos, y divertidos.

Pero al tiempo me di cuenta de que, una vez más, la fuente de dinero principal para desarrollar toda esa tecnología maravillosa eran... los ministerios de Defensa.

Quemado, frustrado y decepcionado por la popularidad de cierto personaje que prometía llevarnos a Marte, dejé la industria de mis sueños y empecé a dar tumbos buscando cuál podría ser mi otra pasión. Pero ya no era tan joven. Y mucho menos después de que alguien muy sabio me abriese los ojos a la triste verdad:

La única manera de asegurarte de que tu trabajo científico no será usado para la guerra: hazlo irrelevante, incorrecto, o ambos.

Tecnologías de guerra

Por todos estos motivos, cuando ayer leí a Marga Padilla en El Salto Diario hablando sobre la "IA", me enfadé bastante (el mismo medio publicó meses atrás una defensa de la "IA" en la Economía Social y Solidaria, así que en todo caso no me pilló de nuevas).

Hemos publicado hoy esta entrevista sobre inteligencia artificial que @irenegrubio.bsky.social y yo mismo hicimos a una de esas personas que ayudan a pensar en términos no manidos. Marga Padilla: “Podemos crear una relación liberadora con la tecnología” www.elsaltodiario.com/pensamiento/...

A alguien le podrá parecer excesivo pasar de hablar de tecnologías militares a la "IA". Vamos a empezar por aquí.

Lo primero que hay que decir es que, como recuerdan Olivia Guest, Iris van Rooij y Abeba Birhane, desde que se acuñó el término "Inteligencia Artificial" en los '50 (por una disputa entre señoros), siempre ha sido un término marketiniano, deliberadamente confuso y ambiguo, para poder alimentar la máquina del hype. Partes de la "IA" se vienen utilizando hace muchos años sin ningún tipo de problema. Según la definición, hasta una inocente regresión lineal podría considerarse "IA".

Elisabet Roselló creó esta representación "imperfecta" que ayuda a situarse o, por lo menos, a entender la necesidad de especificar a qué nos referimos cuando hablamos de "IA".

Con esto en mente, cuando hablo de la "IA" me refiero al ciclo de hype actual, que arrancó en noviembre de 2022 con el lanzamiento de ChatGPT y sigue hasta nuestros días. Estos productos utilizan grandes modelos de lenguaje (LLMs), que son redes neuronales artificiales (ANNs) basadas en la arquitectura de "transformadores", propuesta por investigadores de Google en el famoso artículo de 2017 "Attention is all you need".

Lo segundo que hay que decir es que no soy ni mucho menos el primero en decir que la "IA" es una tecnología de guerra. Simon Wardley (el creador de los mapas de Wardley) la ha llamado "armamento no cinético". Dan McQuillan la ha llamado "thatcherismo algorítmico". Timnit Gebru y Émile P. Torres la han identificado como un pilar clave en las ideologías TESCREAL, muy relacionadas con la Ilustración Oscura y por ende la actual administración Trump.

Por tanto, me van a perdonar quienes dicen que el debate sobre la "IA" solo tiene argumentos "chusqueros", pero tienen mucho que estudiar.

La "IA" son un puñado de vendehumos

Sí, es importante separar la ciencia (mecanismo de atención en redes neuronales) de la tecnología (LLMs) de los productos comerciales (ChatGPT). Y la verdad es que estos últimos tienen un tufo insoportable.

Gran parte de la discusión parece centrada en el impacto ambiental de la "IA". Sí, las emisiones y el consumo de agua de una consulta a ChatGPT pueden ser pequeñas, pero este argumento tiene los pies de barro: la industria está dando cifras interesadas y probablemente muy alejadas de la realidad y los análisis son muy sensibles a las hipótesis de partida. Pero todo esto se desmonta con una pregunta sencilla: ¿cómo es posible que todas las grandes tecnológicas hayan abandonado a la vez sus compromisos climáticos?

Eric Schmidtt, ex CEO de Google, ha llegado a decir que nos tenemos que poner a construir centros de datos a lo loco ¡"porque total, nunca vamos a cumplir nuestros objetivos climáticos de todas formas"!

Para seguir, la forma en la que determinadas empresas han desplegado esta tecnología está dejando mucho que desear. No han sido capaces (o no han querido) ofrecer mecanismos o procesos para detectar dicho contenido de IA. Es decir, nos han dado el veneno, pero no el antídoto. Se ha comparado al contenido sintético generado con IA con la contaminación radioactiva, los microplásticos, o el amianto.

Además, a medida que se destapan más casos de suicidios e incluso asesinatos causados por gente obsesionada con la IA, la respuesta de las empresas no podría haber sido más ruin: "estaban incumpliendo los términos de servicio".

Y para terminar, toda la industria es un agujero negro financiero de proporciones bíblicas. OpenAI, la empresa detrás de ChatGPT, pierde literalmente decenas de millones de dólares cada día (¡o tal vez muchísimo más!) y cada pocos meses tiene que levantar rondas de financiación mastodónticas simplemente para poder sustentar sus operaciones. Anthropic, su rival más directo, no se queda corto. Ed Zitron lleva meses publicando análisis minuciosos de las finanzas de estas empresas que dan una idea del ritmo vertiginoso al que están destruyendo dinero. Pero es que no acaba aquí: muchos medios están alertando ya de que los flujos de dinero en la industria de la "IA" son básicamente un círculo.

En todo esto Marga Padilla y yo estaríamos de acuerdo. Pero lo que dicen ciertas activistas es que la alternativa es colectivizar estas tecnologías y desarrollar nuestra propia "IA": abierta, libre, y sin pesticidas.

¿Seguro?

"El amor a la tecnología"

Aquellas personas capaces de estirar el chicle de que "la tecnología es neutral" deberían informarse un poco más de cómo se han creado los LLMs. Están entrenados con datos robados, refinados por anotadores traumatizados de países del Sur Global, tienen un impacto medioambiental desbocado, y representan unos valores culturales lejos de ser universales.

Marga Padilla acierta cuando dice que las licencias de software libre, por sí solas, no garantizan la soberanía. Es lo que Luis Villa describió como libertad negativa vs libertad positiva. ¡Pero es que el efecto de la "IA" está siendo justamente desmantelar las comunidades de práctica y las relaciones humanas! Ya no hace falta preguntar en un foro, en un grupo de Telegram, o en Stack Overflow: la "IA" te resuelve todas tus dudas de programación. No hace falta pedirle a un compañero que te diga si este email se lee demasiado agresivo o hay que retocarlo: la "IA" te da una versión edulcorada para que tu jefe no se enfade.

Nada de esto, nada cambia si se usan modelos abiertos en vez de cerrados.

Lo primero, no está nada claro qué significa "abierto" en el contexto de la "IA", hasta el punto que ha habido un cisma en la Open Source Initiative a raíz de este tema. No han faltado las acusaciones de "openwashing" a gente como Meta y otras organizaciones.

Pero incluso si tomamos una definición lo suficientemente laxa (pesos abiertos, datos de entrenamiento más o menos conocidos), estás "IAs abiertas" tienen muchísimos problemas.

Las "IAs" abiertas siguen necesitando personas expertas que los ajusten y los modulen para que "aprendan" a dar respuestas. ¿De qué pensáis que vive Mercor, la única empresa junto con Nvidia y las consultoras estratégicas que está ganando dinero con la "IA"?

Las "IAs" abiertas siguen necesitando cantidades ingentes de datos para funcionar. ¿Y de dónde van a salir todos esos datos, si no es de artistas explotados que compartieron sus creaciones en Internet sin imaginar que iban acabar engullidas?

¿Acaso hay mayor traición a la cultura libre que decir que las licencias copyleft en el software o las share-alike en otras formas de producción deben ser ignoradas en favor de la "IA"?

¿Todo esto por "amor a la tecnología"?

No es la primera vez que en nombre de la “cultura de la libertad” se instala la idea de eliminar el copyright. Curiosa “libertad” que está alineada con las BigTech, que son las que más presionan para abolir los derechos de autor y tener ellas la explotación de nuestras obras bsky.app/profile/sega...

El problema que tenemos las personas "técnicas" (término ya de por sí cargado) es que nos pensamos que podemos resolver todos los problemas de la humanidad a golpe de software.

Y en concreto, quienes son (hemos sido) activistas del software libre piensan (pensábamos) que el software libre es la solución a todos los problemas.

De esta forma de pensar también se sale.

Saber "sobre tecnología" o conocer parte de su funcionamiento no te capacita para meterte en camisas de once varas, y menos en nada que implique creación artística y mucho análisis sociocultural, pero difícilmente hay algo más propio de ingenieros que sobredimensionar tus propias capacidades...

Y lo que aún no sabemos

Es hora de ir concluyendo.

La "IA" posiblemente está acelerada por ideologías colonialistas e imperialistas, y lógicas de carrera armamentística contra "los malos".

La "IA" posiblemente no ahorra trabajo, sino que lo desplaza. A ti te cuesta menos escribir ese email: a la otra persona le cuesta más leerlo. A ti te cuesta menos mandar una contribución de código de trece mil líneas: a los mantenedores les costará horrores revisarla y mantenerla.

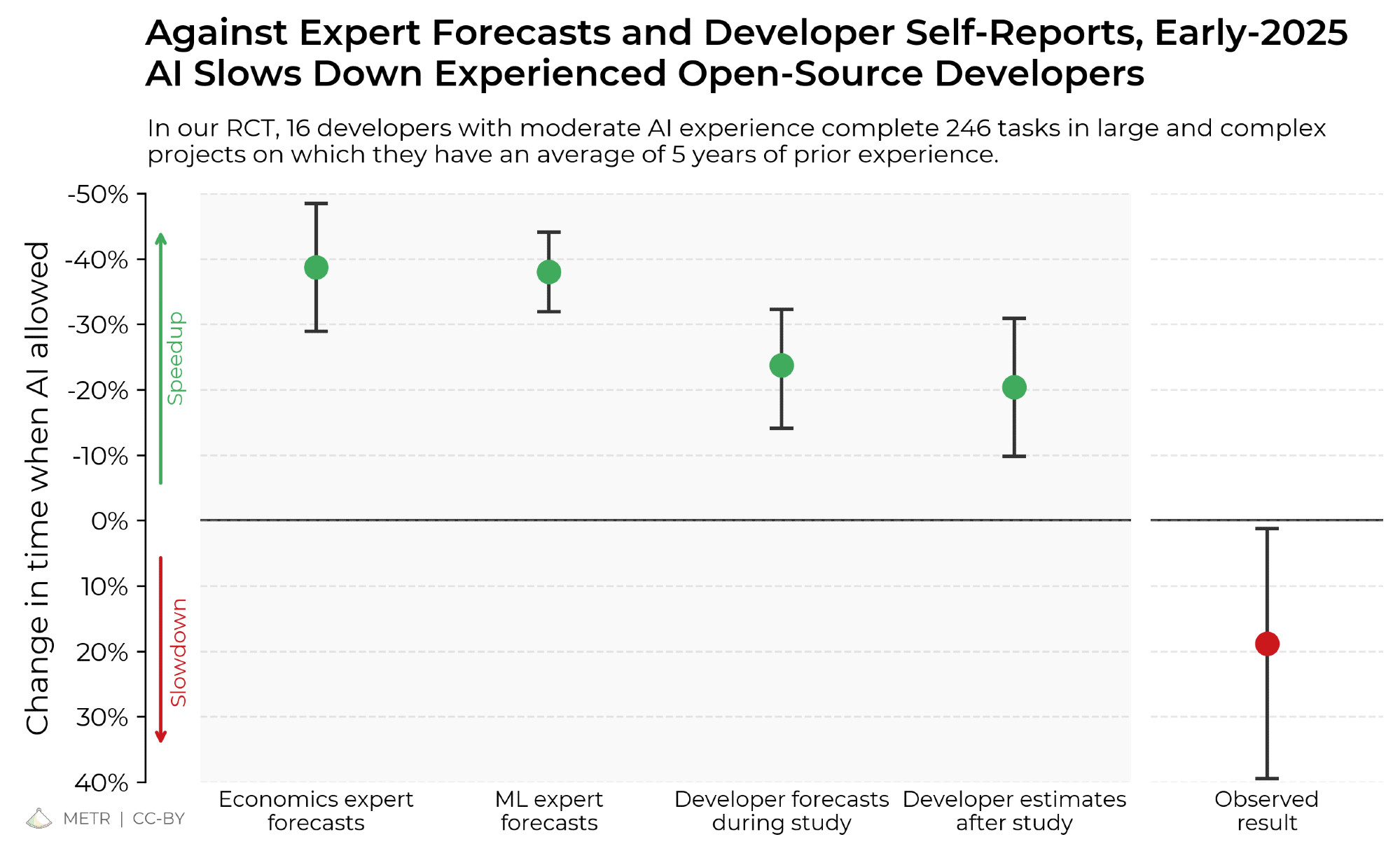

La "IA" posiblemente funciona mucho peor de lo que se piensa, si se excluyen el efecto placebo y se hacen evaluaciones de productividad con rigor científico.

(Que por cierto, ¿qué tal si dejamos de hablar de productividad, como haría torpemente McKinsey, y empezamos a hablar de experiencia?)

La "IA" posiblemente nos hace más tontos. Las comparaciones, manidas ya, con las calculadoras, no sirven. Sí, ¡las calculadoras también nos hacen más tontos! no así los ábacos.

Usar la "IA" es aceptar que las relaciones humanas son un estorbo, un incordio, un mal necesario. Que es mejor tener un "amigo" servil con voluntad flácida que te diga a todo que sí. Que es mejor pedir perdón que permiso.

La "IA" está promovida por visiones supuestamente esperanzadoras basadas en la ciencia ficción. Pero probablemente sus máximos exponentes no entienden el componente de crítica social que encierran esas obras.

Tech bros don’t actually understand the sci-fi they claim to love. Thank you Al Jazeera English for having me on.

La "IA" posiblemente no sea inevitable, como no lo fueron el Metaverso ni los criptoactivos. Es más: posiblemente tenemos que hacer mucho más para resistir contra la "IA".

Es urgente el debate sobre la "IA", y me entristece enormemente que la Economía Social y Solidaria, de la que he sido parte durante 3 años, esté tan mal asesorada. Urge leer a las personas, en su mayoría mujeres racializadas, que llevan denunciando sus peligros durante años. Es urgente dejar atrás la dicotomía "abierto/cerrado" para hablar de una tecnología que dista mucho de ser neutral.

En definitiva, es hora de hacernos mayores y aceptar que incluso la tecnología que más amamos puede tener un uso dual, y que hay que escuchar con atención a las personas afectadas, más allá de nuestra burbuja.